Why Supervisord supervisord 是一个 python 写的守护进程管理工具,功能非常实用。

supervisord 的介绍可以看这篇文章。 在生成环境,celery worker 进程通常会以守护进程的方式运行,而 celery 命令行工具本身是不支持以 daemon 方式运行的,虽然可以 nohup celery worker &的方式让 worker 进程在后台运行,但是当有多个 celery worker 进程时,这种方式管理起来就会变得很麻烦,想要 stop,restart 还得一个个去 kill pid。 supervisord 是 celery 官方推荐的 daemon 管理工具之一,可以对多个进程统一进行监控,管理。

Configuration 配置其实很简单,主要就是设置 supervisord.conf 和 celerd.conf 两个文件。celery 官方还提供了这两个文件的示例

supervisord.conf

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 [unix_http_server] file=/tmp/supervisor.sock ; path to your socket file ;chmod=0777 ;chown=webscan:webscan [inet_http_server] port=1222 username=sinasec password=xxxxxxx [supervisord] logfile=/var/log/supervisord/supervisord.log ; supervisord log file logfile_maxbytes=50MB ; maximum size of logfile before rotation logfile_backups=10 ; number of backed up logfiles loglevel=info ; info, debug, warn, trace pidfile=/var/run/supervisord.pid ; pidfile location nodaemon=false ; run supervisord as a daemon minfds=1024 ; number of startup file descriptors minprocs=200 ; number of process descriptors user=root ; default user childlogdir=/var/log/supervisord/ ; where child log files will live [rpcinterface:supervisor] supervisor.rpcinterface_factory = supervisor.rpcinterface:make_main_rpcinterface [supervisorctl] serverurl=unix:///tmp/supervisor.sock ; use unix:// schem for a unix sockets. ; celery的监控工具flower自身也不支持以daemon方式运行,刚好也可以通过supervisord管理起来。 [program:flower] command=/usr/local/bin/flower --adress=0.0.0.0 --port=1221 autostart=true autorestart=true user=webscan directory=/var/webscan/scanner/ stdout_logfile_maxbytes = 50MB stdoiut_logfile_backups = 20 stdout_logfile = /var/log/flower.log [include] # Uncomment this line for celeryd for Python files=celeryd.conf # Uncomment this line for celeryd for Django. ;files=django/celeryd.conf

基本上就是官方那个配置文件,拿过来加上了 flower 的设置。

celerd.conf

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 [program:celery] command=celery worker --hostname=celery-%(process_num)d.webscan.com --loglevel=INFO process_name = %(program_name)s-%(process_num)d environment=PYTHONPATH=/var/webscan/scanner/ directory=/var/webscan/scanner user=webscan numprocs=4 stdout_logfile=/var/log/celeryd.log stderr_logfile=/var/log/celeryd.log autostart=true autorestart=true startsecs=10

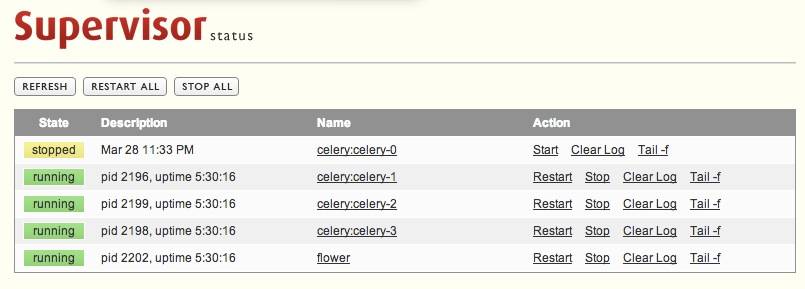

这个设置里比较不同的是 numprocs 我设置成了 4,既 celery worker 进程会同时起 4 个,分别命名 celery-0 ,celery-1。之所以要在一台机器上起 4 个 worker 进程,是因为我们的 celery pool 用的是 gevent,而为了充分利用多核,因此一台机器上需要起 4 个 worker。

Usage 上面的设置都完成后先启动 supervisord

1 supervisord -c /etc/supervisord.conf

然后就可以通过 supervisorctl 对这些进程进行管理了:

1 2 supervisorctl restart flower supervisorctl stop celery:celery-0

浏览器访问http://10.1.1.1:1222/ 还可以通过 web 对这些进程进行管理